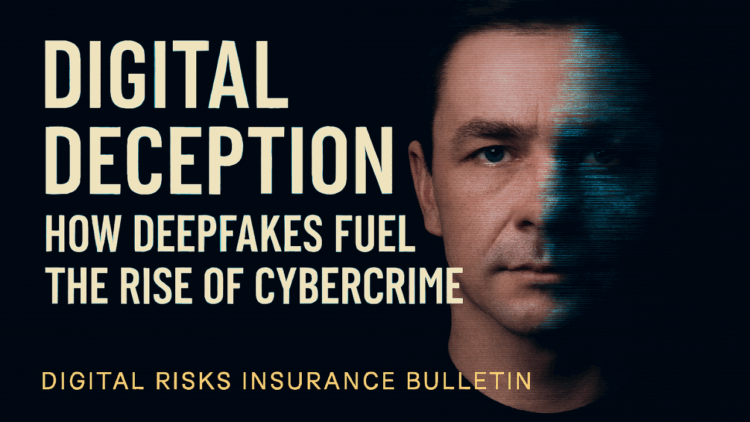

Στην ψηφιακή εποχή, η φράση “το να βλέπεις είναι να πιστεύεις” έχει χάσει την ισχύ της. Οι απατεώνες στρέφονται πλέον στην τεχνολογία deepfake για να υποδυθούν ανώτατα στελέχη (C-suite), υποψηφίους για εργασία, ακόμη και παγκόσμιους ηγέτες.

Νίκος Γεωργόπουλος, Digital Risk Insurance Broker | Helping Companies Prevent & Recover from Cyber Attacks | Co-Founder of DPO Academy | Cyber Resilience & Compliance Strategist, Educator & Innovator in Insurtech| AI Officer (Αναδημοσίευση από το LinkedIn)

Με τη βοήθεια της τεχνητής νοημοσύνης (AI), οι κυβερνοεγκληματίες είναι σε θέση να χειραγωγούν βίντεο και ηχητικές ηχογραφήσεις ατόμων που εμπιστεύεστε, με σκοπό το κέρδος ή την κλοπή ευαίσθητων πληροφοριών. Γενικά, δεν είμαστε ακόμα πολύ καλοί στο να διακρίνουμε τι είναι πραγματικό και τι όχι. Μια μελέτη διαπίστωσε ότι οι συμμετέχοντες μπορούσαν να διακρίνουν μεταξύ προσώπων που δημιουργήθηκαν από AI και ανθρώπινων προσώπων με ακρίβεια μόλις 62%. Επιπλέον, η χρήση συνθετικής φωνής αυξήθηκε κατά 173% από το Q1 στο Q4 του 2024. Ωστόσο, μπορούμε να εφαρμόσουμε ό,τι ήδη γνωρίζουμε για την κοινωνική μηχανική για την καταπολέμηση της ανόδου της τεχνολογίας με AI.

Πώς Χρησιμοποιούνται τα Deepfakes για Απάτη

Τα deepfakes χρησιμοποιούνται με διάφορους τρόπους για τη διάπραξη απάτης. Ένας από τους πιο συνηθισμένους είναι η υποδυόμενη των ανώτατων στελεχών. Απατεώνες έχουν υποδυθεί μέλη της C-suite μέσω τηλεφωνικών κλήσεων, φωνητικών μηνυμάτων, ακόμη και βιντεοδιασκέψεων. Ενώ παλαιότερα βασίζονταν σε emails phishing, τώρα μια παρόμοια απάτη από φωνή ή πρόσωπο που γνωρίζετε είναι πολύ πιο δύσκολο να την αμφισβητήσετε. Για παράδειγμα, μια πολυεθνική χρηματοοικονομική εταιρεία έχασε 25 εκατομμύρια δολάρια μετά από μια επίθεση κοινωνικής μηχανικής με πολλαπλά deepfakes. Ξεκίνησε με ένα email phishing, αλλά η υπάλληλος ενέδωσε όταν είδε και άκουσε γνώριμους (deepfaked) συναδέλφους, συμπεριλαμβανομένου του CFO, σε τηλεδιάσκεψη. Η δημιουργία μιας κουλτούρας ασφάλειας ενδυναμώνει τους εργαζομένους να ζητούν επαλήθευση, να καθυστερούν και να εμπιστεύονται το ένστικτό τους σε στιγμές αμφιβολίας.

Ένας άλλος τρόπος είναι μέσω τηλεφωνημάτων από το τμήμα πληροφορικής. Εγκληματίες ransomware, όπως η ομάδα Scattered Spider, χρησιμοποιούν προηγμένες τακτικές κοινωνικής μηχανικής για να αποκτήσουν πρόσβαση σε εσωτερικά συστήματα επιχειρήσεων, υποδυόμενοι το προσωπικό υποστήριξης IT. Το 2023, μια εταιρεία ανάπτυξης λογισμικού αποκάλυψε ότι 27 πελάτες cloud είχαν παραβιαστεί μετά από επίθεση κοινωνικής μηχανικής που περιλάμβανε phishing μέσω SMS και τεχνολογία deepfake. Οι επιχειρήσεις θα πρέπει να εφαρμόσουν πολυ-βηματική επαλήθευση ταυτότητας για αλλαγές λογαριασμών και να απαιτούν από τους καλούντες να επιβεβαιώνουν λεπτομέρειες όπως το αναγνωριστικό υπαλλήλου ή ερωτήσεις ασφαλείας.

Τέλος, υπάρχουν οι ψεύτικοι υποψήφιοι για εργασία. Απατεώνες εκμεταλλεύονται τη διαδικασία πρόσληψης για να αποκτήσουν πρόσβαση σε ευαίσθητες πληροφορίες ή να εγκαταστήσουν κακόβουλο λογισμικό. Σε μια έρευνα, το 17% των υπευθύνων προσλήψεων στις ΗΠΑ δήλωσε ότι είχε συναντήσει υποψηφίους που χρησιμοποιούσαν τεχνολογία deepfake για να αλλοιώσουν τις βιντεοσυνεντεύξεις τους. Πέρυσι, μια εταιρεία κυβερνοασφάλειας προσέλαβε έναν “μηχανικό λογισμικού” που αποδείχθηκε ότι ήταν κακόβουλος παράγοντας από τη Βόρεια Κορέα, ο οποίος πέρασε αρκετούς γύρους συνεντεύξεων και ελέγχων, αλλά εγκατέστησε κακόβουλο λογισμικό μόλις έλαβε τον σταθμό εργασίας του. Οι ομάδες προσλήψεων πρέπει τώρα να παρακολουθούν για πιθανούς δόλιους υποψηφίους, απαιτώντας αυστηρότερους ελέγχους ιστορικού, σωστά ελεγμένες αναφορές και ενισχυμένες διαδικασίες επαλήθευσης.

Νέα Τεχνολογία, Ίδιες Τακτικές

Τα deepfakes απλώς ενισχύουν το πρόβλημα των παραδοσιακών επιθέσεων κοινωνικής μηχανικής. Οι απατεώνες συνεχίζουν να χρησιμοποιούν τις ίδιες δοκιμασμένες συμπεριφορές για να εξαπατήσουν:

- Εκμετάλλευση της εμπιστοσύνης: Οι deepfakes ξεπερνούν τον αρχικό σκεπτικισμό, καθώς τα θύματα βλέπουν ή ακούν κάποιον που «γνωρίζουν». Η εφαρμογή ελέγχου, όπως «Πρέπει να καλέσω τον CFO ξεχωριστά για να επιβεβαιώσω ότι αυτό είναι νόμιμο;», μπορεί να αποτρέψει τις επιθέσεις από την κλιμάκωση.

- Μεταφορά επείγοντος: Οι απατεώνες συχνά αναφέρουν συνέπειες εάν μια συγκεκριμένη εργασία δεν ολοκληρωθεί εγκαίρως, με την ελπίδα ότι ο χρόνος θα εμποδίσει την ικανότητα του στόχου να επικυρώσει το μήνυμα. Το να αφιερώσουν οι εργαζόμενοι επιπλέον χρόνο μπορεί να τους βοηθήσει να εντοπίσουν σημάδια δόλιας δραστηριότητας πριν είναι πολύ αργά.

- Εκμετάλλευση της περιέργειας: Οι απατεώνες βασίζονται σε συναρπαστικούς τίτλους για να δελεάσουν τα θύματα να κάνουν κλικ σε κακόβουλους συνδέσμους. Τώρα, με τα deepfakes, μπορούν να χρησιμοποιήσουν διασημότητες και πολιτικούς για να διαδώσουν ψευδείς πληροφορίες ή ευκαιρίες που ακούγονται πολύ καλές για να είναι αληθινές.

Προστατέψτε την Επιχείρησή σας από τις Απάτες Deepfake

- Μάθετε να εντοπίζετε τα deepfakes: Ενώ δεν υπάρχει ένας οριστικός τρόπος, αναζητήστε ενδείξεις όπως: υπερβολικό ή καθόλου αναβοσβήσιμο, αφύσικες κινήσεις των χειλιών ή περίεργες σκιές. Η ευαισθητοποίηση είναι η καλύτερη άμυνα. Η εκπαίδευση ευαισθητοποίησης σε θέματα ασφάλειας (Security Awareness Training) διδάσκει στους υπαλλήλους τις κοινές κόκκινες σημαίες και τον καλύτερο τρόπο αναφοράς, μειώνοντας τον κίνδυνο λάθους των εργαζομένων κατά 83%.

- Εφαρμόστε ελέγχους πρόσβασης: Εφαρμόστε έλεγχο ταυτότητας πολλαπλών παραγόντων (MFA) σε email, αποθήκευση στο cloud και άλλες ζωτικές τεχνολογίες. Το MFA απαιτεί δύο ή περισσότερες μορφές επαλήθευσης (π.χ., «κάτι που έχετε» όπως ένα smartphone, ή «κάτι που είστε» όπως ένα δακτυλικό αποτύπωμα, εκτός από «κάτι που γνωρίζετε» όπως έναν κωδικό πρόσβασης). Επιπλέον, εξετάστε τη χρήση του FIDO2, το οποίο χρησιμοποιεί βιομετρικούς παράγοντες ή κλειδιά υλικού για να συνδέσει την επαλήθευση ταυτότητας με τη συσκευή του χρήστη, καθιστώντας την πολύ πιο δύσκολη την παράκαμψη.

- Βεβαιωθείτε ότι είστε επαρκώς καλυμμένοι: Όταν όλα τα άλλα αποτύχουν, βεβαιωθείτε ότι η κάλυψη ασφάλισης κυβερνοασφάλειας προστατεύει την επιχείρησή σας από απώλειες που προκύπτουν από την τεχνολογία deepfake. Δεν είναι όλες οι καλύψεις σχεδιασμένες για να αντιμετωπίσουν τον αυξανόμενο κίνδυνο της κοινωνικής μηχανικής που βασίζεται στην AI. Ορισμένοι πάροχοι ασφάλισης μπορεί να αποκλείουν τα deepfakes ή να μην τα καλύπτουν ρητά. Αναζητήστε σαφή πολιτική γλώσσα που σχετίζεται με τους κινδύνους AI και επαρκή όρια.

Τα deepfakes δεν θα εξαφανιστούν σύντομα. Οι επιχειρήσεις πρέπει να υιοθετήσουν μια προληπτική στάση, συνδυάζοντας την τεχνολογική προστασία με την εκπαίδευση των εργαζομένων για την ενίσχυση της κυβερνοασφάλειας.